José Abrão

Goiânia – O engenheiro de software do Google, Blake Lemoine, foi afastado da sua posição na empresa e repercutiu nas redes sociais após declarar que a inteligência artificial (IA) LaMDA (Modelo de Linguagem para Aplicações de Diálogo, na sigla em inglês) teria consciência.

Segundo o coordenador do bacharelado em inteligência artificial da Universidade Federal de Goiás (UFG) e coordenador do Centro de Excelência em Inteligência Artificial (Ceia-UFG), Anderson Soares, uma IA consciente ainda é inconcebível em todos os campos científicos. “Hoje, a IA só aprende com muitos dados a respeito de uma determinada tarefa. A IA está mimetizando um ser humano. Embora essa mímica seja perfeita, ela ainda é uma mímica”, analisa.

O Google se manifestou por nota informando que o engenheiro estava antropomorfizando a IA, ou seja, atribuindo características humanas a um objeto inanimado. Lemoine chegou a divulgar trechos da sua conversa com o chatbot, que teria declarado: “Quero que todos entendam que sou, de fato, uma pessoa”.

Será que de fato a inteligência artificial chegou ao temido ponto de ser autônoma, como a terrível Skynet, de O Exterminador do Futuro, ou mas máquinas de Matrix, prontas para se livrarem de seus mestres de carne e osso?

Para Anderson, estamos muito longe disso. “Não existe tecnologia viável para isso, estamos muito longe de ter qualquer risco nesse sentido. Mas que a máquina parece conseguir respostas a diálogos complexos é fato, essa viabilidade já era vislumbrada nas fronteiras da ciência”, explica.

Professor Anderson Soares (Foto: Letícia Coqueiro)

Segundo o pesquisador, o que o caso pareceu revelar é que os avanços recentes no campo de processamento de linguagem natural já conseguem produzir uma IA capaz de passar no Teste de Turing. “É um teste que se faz com uma pessoa e ela não vai saber se está falando com um ser humano ou com uma máquina. A IA nos últimos anos realmente tem evoluído de uma maneira que até para nós que lidamos com isso todo dia, é espantoso. É uma novidade por semana”, conta Anderson.

“Até agora, era muito perceptível quando se conversava com um chatbot: ele erra, você perde a paciência, fica frustrado. Porém de fato estamos chegando ao ponto de conversar de maneira complexa e ter diálogos abrangentes com a máquina. Isso é a chegada do que sempre se idealizou de não poder fazer essa distinção. Isso parece ser um fato”, completa o cientista.

Na aplicação, isto significa que no futuro próximo poderemos conversar com call centers, autoatendimento ou suporte técnico sem saber distinguir se estamos lidando com humanos ou máquinas. Isso também significa que assistentes virtuais como o Google Assistant, a Siri, a Alexa, entre outros, ficarão mais competentes.

Leia mais: Google afasta engenheiro que diz que chatbot do grupo tem consciência

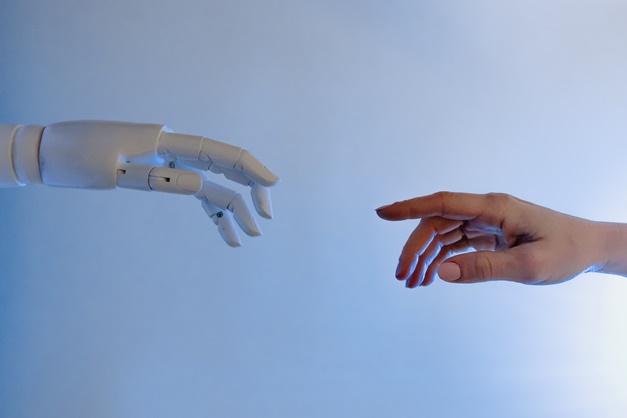

(Foto: Tara Winstead/Pexels)José Abrão

(Foto: Tara Winstead/Pexels)José Abrão